汪天富教授团队在消化道疾病智能辅助诊断领域发表系列研究成果

发布时间:2023-12-31

几年里,消化道疾病在全球范围内高发,成为威胁人类生命健康的主要杀手之一。内窥镜检查作为现代消化道疾病诊疗的重要手段,对降低死亡率具有重要意义。近期,我院汪天富教授团队针对该领域的挑战,从内窥镜图像质量评价、内窥镜图像质量增强、疾病智能筛查、以及结直肠息肉智能分割等角度进行了系列创新性研究。这些研究对于提升疾病筛查的准确性、提高疾病诊疗效率具有重要意义。以下是对团队的几项代表性工作的简要介绍。

内窥镜图像质量评价

受成像条件、医生操作手法以及病人准备情况等因素影响,采集的内窥镜图像通常伴随质量衰退问题(如低对比度、模糊、噪声等),不仅降低了视觉感知效果,同时为识别和分析疾病带来了挑战。为解决这一难题,科研人员近年来开发了多种低照度图像增强算法,以改善内窥镜图像的质量。然而,公正地评估这些增强算法对内窥镜图像质量的提升效果,仍然是一个充满挑战的难题。为解决该难题,课题组近期开展了大量研究,在业内顶级期刊 IEEE Transactions on Circuits and Systems for Video Technology (TOP期刊, 中科院一区,IF=8.4)上发表了题为 “Perceptual Quality Assessment of Enhanced Colonoscopy Images: A Benchmark Dataset and an Objective Method” 的研究论文。论文第一作者是团队副教授岳广辉,第二作者是硕士研究生程地。

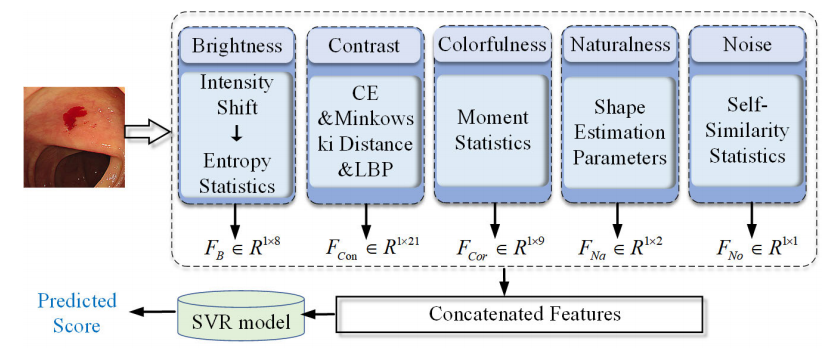

本研究对内窥镜图像质量评价问题进行了系统性探究。首先,鉴于该领域缺乏专有的数据集,本研究收集了300张低照度内窥镜图像,利用8种流行的低照度图像增强方法处理这些图像以生成2400张增强图像;开展主观实验,评估这些图像的质量分数,并基于数据分析建立了一个基准数据集(ECIQAD)。其次,针对增强内窥镜图像的失真特性,提出了一种无参考增强结肠镜图像质量评估方法(ECIQ),如图1所示。该方法综合考量亮度、对比度、色彩度、自然度和噪声等失真因素,自动评估ECI图像的感知质量。在构建的数据集上的大量实验表明, ECIQ优于14种主流的无参考图像质量评估方法。

图1 ECIQ框架图

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10078370

内窥镜图像质量增强

弱光封闭环境下采集的内窥镜图像通常可见度较差,影响了医生的工作效率和病灶检测的准确性。然而,大多数图像增强方法在处理弱光内窥镜图像增强任务时表现不佳,通常会带来额外的伪影或放大噪声。为解决该问题,团队在低照度内窥镜图像增强领域做出了诸多探索,相关成果发表在业内顶级期刊IEEE Transactions on Circuits and Systems for Video Technology(TOP期刊, 中科院一区,IF=8.4) 上发表,论文题目为“Deep Pyramid Network for Low-light Endoscopic Image Enhancement”。论文第一作者是团队副教授岳广辉,第二作者是硕士研究生高杰。

本研究提出了一种深度金字塔增强网络(DPENet,图2),可以从全局和局部角度增强内窥镜图像。具体而言,考虑到内窥镜图像的照明不均匀,DPENet 利用具有三个并行分支的图像金字塔框架来探索和集成不同尺度的全局和局部特征。为了抑制噪声,DPENet 在每个分支中设置多个尺度空间特征提取块(SFEB)。SFEB 由上下文特征提取模块(CFEM)和空间残留注意模块(SRAM)组成。CFEM 挖掘上下文信息,帮助网络理解语义信息,同时抑制孤立噪声。SRAM 利用空间注意力机制来帮助网络自适应地关注昏暗区域。在多个数据集上的实验结果表明,DPENet 能够胜任弱光内窥镜图像增强任务且优于主流图像增强算法。

图2 DPENet 框架图

论文链接:https://ieeexplore.ieee.org/document/10274690

疾病智能筛查

多中心并存是目前医疗体系的一大特色。为综合利用多中心的数据并保护数据隐私,联邦学习在近年来得到了研究者们的关注。然而,大多数方法直接在服务器上对收集的医疗客户端本地模型参数进行平均,而忽视了医疗客户端的特殊性。此外,各个中心的数据集中普遍存在的类别不平衡问题,为疾病准确筛查提出较大的挑战。为应对该挑战,团队近期在基于联邦学习的疾病智能筛查领域做出了诸多探索,取得的研究成果发表在业内顶级杂志IEEE Journal of Biomedical and Health Informatics(TOP期刊, 中科院一区,IF=7.7)上,论文题目为“Specificity-aware Federated Learning with Dynamic Feature Fusion Network for Imbalanced Medical Image Classification”。团队副教授岳广辉、硕士研究生魏佩珊为该文章共同第一作者。

本研究引入了一种特征融合的特异性感知联邦学习框架。考虑到每个本地模型的特殊性,本研究在服务器上设置自适应聚合机制(AdapAM)。AdapAM利用强化学习,根据局部模型的数据分布和性能反馈,自适应地对模型参数进行加权和聚合,从而获得全局模型参数。针对局部数据集中的类不平衡问题,提出了基于不平衡比例的动态特征融合策略(DFFS)来动态融合主要类的特征(图3)。在多个公开数据集上的实验表明,本研究所提方法在疾病分类领域优于主流的联邦学习方法。

图3 基于联邦学习的疾病分类框架图

论文链接:https://ieeexplore.ieee.org/document/10264099

结直肠息肉智能分割

团队在结直肠内窥镜图像息肉分割领域也取得新的研究成果,并在人工智能领域顶级期刊Neural Networks(TOP期刊, 中科院一区,IF=7.8)上发表题为“Boundary Uncertainty Aware Network for Automated Polyp Segmentation”的论文。论文第一作者是团队副教授岳广辉,第二作者是硕士研究生卓桂彬。

结直肠内窥镜图像息肉分割任务的难点在于:

1)图像的背景复杂多变,息肉病灶的形状和大小差异较大,

2)息肉病灶与其周围的组织相似度高,边界模糊不清晰。

为解决这两个问题,现有的方法多从如何提高模型的特征提取能力的角度出发,并基于卷积神经网络设计相应的特征提取模块。本研究则采取了不同的策略,为提高模型的全局上下文建模能力,本研究使用了金字塔视觉Transformer 模型 PVT-v2来提取多尺度和强大的特征表示,以捕获不同尺寸的息肉和复杂的背景信息。同时,由于息肉病灶边界模糊不清,模型在分割息肉边界时存在易出错的区域,提出了一种新颖的边界不确定性感知网络框架 BUNet 。该网络框架图如图4所示,图像经过以 PVT-v2 视觉Transformer 编码器得到不同尺度的特征图,低层特征图经过 BEM 模块学习边界特征,高层特征图经过边界不确定性感知模块,以及前景和背景的联合监督对边界不确定性区域进行修正,最终得到精确的息肉分割图。本研究在多个公开息肉分割数据集上进行了大量实验,实验结果表明所提网络在息肉分割任务上的表现优于主流方法。

图4 BUNet框架图

论文链接:https://www.sciencedirect.com/science/article/abs/pii/S0893608023006731

以上研究依托于广东省生物医学信息检测与超声成像重点实验室和医学超声关键技术国家地方联合工程实验室开展,并得到了国家自然科学基金、广东省自然科学基金、深圳市自然科学基金、腾讯“犀牛鸟”、深圳大学青年教师科研基金等项目的资助。

上一篇: 医学部倪东教授团队在Medical Image Analys...

下一篇: 深大BME校友会活动之——医院岗位简介会